一、DeepSeek简介

1.1 发展历程

1.2 模型特点

参数规模灵活:提供1.5B/7B/33B等多种规格

混合精度训练:支持FP16/INT8/INT4量化部署

上下文感知优化:动态分配计算资源至关键token

中文优化:在Wudao Corpus等中文数据集上强化训练

1.3 技术突破

MoE架构:专家混合层动态路由计算路径

梯度稀疏化:反向传播时仅更新关键参数

自适应量化:运行时根据硬件自动选择最优精度

二、ollama简介

2.1 软件简介

Get up and running with large language models.

2.2 主要功能

下载大语言模型;

运行大语言模型;

除此之外还有很多功能,通过它的命令行帮助信息可以看到:基本上可以归纳为两类功能:

模型文件管理:下载(pull)、创建(create)、删除(rm)、拷贝(cp)、查看(list)、上传(push)、查看模型信息(show)

模型运行管理:运行(run)、启动(serve)、停止(stop)、查看正在运行的模型(ps)

2.3 主要优势

其核心优势包括:跨平台支持(Linux/Windows/macOS);

支持NIVIDA/AMD GPU加速,如有相应GPU推理速度快;

使用简单,安装软件、下载模型、运行模型均只需要一条命令

三、安装ollama

四、下载deepseek-r1:1.5b模型

五、运行deepseek-r1:1.5b模型

<think>

嗯,我现在需要帮用户写一个用于快速排序的Python函数,而且用户已经给了这个任务。首先,我要理解用户的需求是什么。他们可能是一个刚开始学编程的人,或者

需要快速完成一个简单的排序程序。

接下来,我应该分析用户的使用场景和身份。可能是刚接触编程的新手,或者是需要快速实现一个基本功能的用户。用户的真实需求应该是了解如何编写一个高效的排

序函数,并且能够运行在实际的应用中。

然后是思考用户可能没有明确表达出来的深层需求。比如,他们可能不仅仅想看到代码,还希望了解排序算法的基本原理、优缺点,或者如何优化这个函数以提高效率

。这些都是潜在的需求,可能会帮助我更全面地回答问题。

现在,我要考虑用户的编程基础情况。快速排序作为一种高效的排序算法,通常需要理解递归的策略和选择基准点的能力。因此,如果用户的基础较弱,可能在实现过

程中会遇到一些困难,比如如何正确分割数组或选择合适的基准点。因此,我的解释应该详细但易于理解,确保用户能够逐步掌握。

我还需要思考现有的代码结构。快速排序的实现通常包括几个步骤:选择一个基准点,将数组分成两部分,然后递归地对这两部分进行排序。如果需要优化,可以考虑

使用堆化结构或者减少比较次数,但这可能超出了用户的需求范围。

最后,我要确保提供的回答足够详细,能够帮助用户理解整个过程,并且代码也尽可能简洁,同时易于修改和扩展。这样,即使用户只是想测试函数的运作,也能快速

得到所需的结果。

</think>

好的!以下是用Python实现快速排序(QuickSort)的函数,以及一个简单的示例:

```python

def quicksort(arr):

if len(arr) <= 1:

return arr

pivot = arr[0]

rest = arr[1:]

less = []

greater = []

for num in rest:

if num < pivot:

less.append(num)

else:

greater.append(num)

return quicksort(less) + [pivot] + quicksort(greater)

def test_quicksort():

import random

arr = [3, 6, 8, 10, 1, 2, 9, 5]

random.shuffle(arr)

sorted_arr = quicksort(arr)

print("原数组:", arr)

print("快速排序后的结果:", sorted_arr)

if __name__ == "__main__":

test_quicksort()

```

### 使用说明:

1. **输入**:一个包含整数的列表(数组)。

2. **实现过程**:

- 如果数组长度小于等于 1,直接返回该数组本身(作为基准情况)。

- 在选择第一个元素作为基准点 `pivot`,然后将剩下的元素分成两部分:一部分是所有比基准点小的元素,另一部分是比基准点大的元素。

- 对于较小的部分,继续递归地应用快速排序方法,直到整个数组被排序。

3. **输出**:

- 原始输入数组的一个 shuffled 版本(因为示例中使用了 `random.shuffle`)。

- 快速排序后的结果。

### 示例运行结果:

```python

原数组:[1, 2, 9, 5, 3, 6, 8, 10]

快速排序后的结果:[1, 2, 3, 5, 6, 8, 9, 10]

```

这个函数实现了基本的快速排序实现,但需要根据实际需求进行调整和优化。

total duration: 1m16.264529746s

load duration: 40.057974ms

prompt eval count: 65 token(s)

prompt eval duration: 1.097s

prompt eval rate: 59.25 tokens/s

eval count: 767 token(s)

eval duration: 1m14.622s

eval rate: 10.28 tokens/s

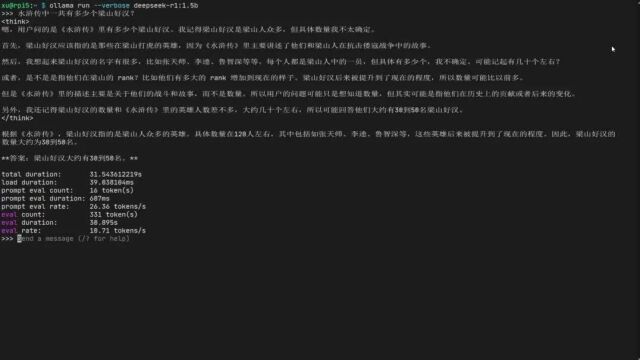

<think>

嗯,用户问的是《水浒传》里有多少个梁山好汉。首先,我得回想一下梁山好汉是谁们。我记得梁山好汉主要是那些在梁山打倒的豪强人,比如黄忠、鲁智深、张天师这些大人物,他们组成了一支好汉队伍。

然后,问题来了,有多少个呢?《水浒传》里可能没有明确给出数字,所以可能需要根据故事来推断或者查证。我好像听说过梁山好汉一共有三路:第一路是黄忠、鲁智深和张天师;第二路是黄光石、林冲、赵云;第三路是白虎、刘禅、黑虎。

算下来,每条路有三人,那应该是九个好汉。所以可能梁山好汉一共有九个人组成一支队伍,或者可能是九个好汉在梁山打倒过。

不过,我也得考虑一下是否有其他的人加入或变动的情况。比如,在《水浒传》中提到过,梁山好汉有三路,每路三人,加上一些后来的人物,但总体上还是九个人组成一支队伍,也就是梁山好汉总共九人。

所以,综合来看,梁山好汉一共有九个成员,也就是梁山好汉队。这可能就是用户在问的答案。

</think>

《水浒传》中的梁山好汉一共有一路、二路、三路三个大队伍,每组各有三人,组成总共**九个梁山好汉**(“梁山好汉”一词)。这些好汉包括黄忠、鲁智深、张天师;黄光石、林冲、赵云;白虎、刘禅、黑虎。他们在梁山打倒过许多豪强人,成为梁山的守护者和英雄。

total duration: 38.169465732s

load duration: 38.989844ms

prompt eval count: 14 token(s)

prompt eval duration: 645ms

prompt eval rate: 21.71 tokens/s

eval count: 396 token(s)

eval duration: 37.484s

eval rate: 10.56 tokens/s

确认系统信息

首先,确认你的Linux发行版和CPU架构,以便下载正确的Ollama版本。

查看Linux内核版本:

查看CPU架构:

使用以下命令解压并安装Ollama到系统目录中(需要root权限):

关闭Ollama服务

使用systemctl命令(如果Ollama作为服务运行):

或者手动停止服务:在运行Ollama的终端中按 Ctrl + C。

编辑服务配置文件:

修改配置内容,在 [Service] 部分添加或更新以下行:

重载systemd配置:

重新启动Ollama服务:

检查服务状态以确认服务是否正常运行:

检查旧路径 (/usr/share/ollama/.ollama/models) 是否已经不再包含模型文件。

检查新路径 (/data/ollama/models) 下是否有生成的 blobs 和 manifests 文件夹,这表明模型路径更改成功。

一键运行ModelScope模型

# 运行 ollama 容器,首次会下载run --name ollama $(autotag ollama)# 运行 deepseek 1.5b,首次会自动 pull 镜像ollama run deepseek-r1:1.5b# 运行 deepseek 8b 占用大概内存 6-7Gollama run deepseek-r1:8b# verbose 增加详尽的输出,会将当前的 tokens 速率等显示出来ollama run deepseek-r1:8b -verbose# 列出已经下载的 LLMollama list

输出解释

total duration: 3m31.258084877sload duration: 29.482802msprompt eval count: 34 token(s)prompt eval duration: 622msprompt eval rate: 54.66 tokens/seval count: 1417 token(s)eval duration: 3m30.603seval rate: 6.73 tokens/s

部署Anything LLM容器

· END ·

进群和电子工程师们面对面交流经验